Il tuo sito piace a Google? Scoprilo leggendo le statistiche di scansione

All’interno della Google Search Console (il caro vecchio Webmaster Tools) puoi verificare uno dei dati diagnostici più importanti che Google ci fornisce: le statistiche di scansione relative agli ultimi 90 giorni, in inglese “Crawl Budget“.

Il crawl budget è un indicatore che riguarda il comportamento di Googlebot sul nostro web server, ci dice quanti file come file HTML, CSS, JavaScript, Flash, PDF e immagini vengono scansionati (o scaricati) ogni giorno, quanti kilobyte vengono scaricati e quanto impiega il web server a fornire i file.

Google non ha problemi a scansionare grandi siti, sotto i 100.000 URL non ha senso preoccuparsi del crawl budget (parola di John Mueller).

Le statistiche di scansione ottimali

- Pagine sottoposte a scansione giornalmente: un buon valore di pagine scansionate ogni giorno corrisponde al totale delle pagine del sito. Un sito web con una media reputazione ottiene facilmente tante scansioni quante sono le pagine che lo compongono. Valori di scansione inferiori al numero di pagine che compongono il sito indicano uno scarso interesse di Googlebot a visitare le pagine. Un valore più alto del numero totale di pagine è molto positivo, perchè significa che Google è affamato dei nostri contenuti e li scansiona di frequente per trovare variazioni, ovvero contenuti nuovi o aggiornati.

- Kilobyte scaricati giornalmente: questo dato è direttamente proporzionale alle pagine scansionate. Dividendo il valore di Kilobyte per il numero di pagine scansionate giornalmente si ottiene il “peso medio” di ogni file scaricato. Ovviamente più è basso il valore medio più sarà semplice e veloce per Google ottenere questi file.

- Tempo trascorso per il download di una pagina: il tempo di download è un parametro cruciale, più è veloce il web server a fornire i file e più veloce potrà lavorare Googlebot. Un valore medio non ottimale è superiore al secondo, un valore buono è inferiore al secondo, un valore ottimale è inferiore al mezzo secondo

In questa immagine puoi vedere come influisce sulle statistiche di scansione un cambio di template: Googlebot effettua un deep crawl del sito web perchè trova variazioni sostanziali su tutte le pagine.

Come aumentare il crawl budget

- Il PageRank di ciascuna pagina influisce sulla sua singola frequenza di scansione. Detto in altre parole significa che aumentando il numero di backlink di qualità che puntano al nostro sito, aumenteremo anche la frequenza con la quale Googlebot tornerà a visitarci.

- Il tempo di risposta e il carico del nostro web server (Host Load) influiscono sul crawl budget. Può capitare infatti che Googlebot metta alla prova il web server richiedendo un numero sempre crescente di risorse per vedere fino a quando riesce a “stare dietro” alle richieste. Quando il web server inizia a rallentare, ovvero a fornire le risorse più lentamente, Googlebot riduce il crawl rate fino ad arrivare ad un livello che non “disturba” il web server in modo da non intasarlo. Googlebot quindi ci assegna un crawl rate personalizzato ad hoc per il nostro web server, più potente e veloce sarà il nostro host ed un numero maggiore di file potrà inviare al goloso Googlebot.

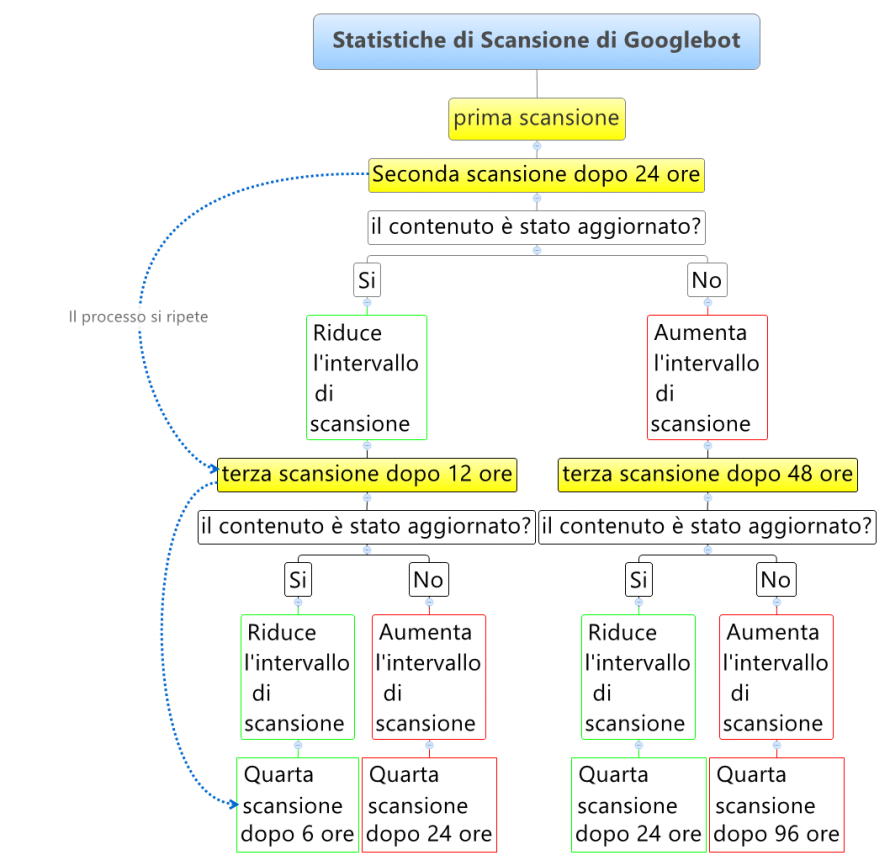

- La frequenza di aggiornamento dei contenuti influisce sulle statistiche di scansione. Questo concetto lo trovate spiegato nell’infografica che segue.

- Googlebot viene anche “invitato” a visitare una data pagina web in base ai +1 ricevuti su Google Plus.

- Nel video a fondo pagina l’analista di Google afferma che ci sono 5 parametri che influiscono sulle statistiche di scansione, due li sappiamo, due li ha detti e poi si è fermato titubante con un “I’m not sure what can I say…”. Quindi lascio il 5° punto in attesa :)

In grafico che segue ho sintetizzato il comportamento di Googlebot in base all’aggiornamento dei contenuti. In pratica se Googlebot ogni volta che torna sul nostro sito trova contenuti aggiornati, tenderà a ridurre costantemente gli intervalli di scansione e quindi il crawl budget. Un portale nazionale di notizie come ANSA verrà visitato praticamente ogni 5 secondi (probabilmente anche più spesso) da Googlebot. Al contrario, se Google ogni volta che ci visita non trova niente di nuovo, tenderà ad allungare costantemente la frequenza di scansione riducendo il crawl budget.

PS: se stai pensando di fregare Googlebot inserendo in homepage un elemento che varia costantemente (la data, un testo, gli articoli mostrati, …) per aumentare il crawl budget… Bè sappi che è un trucco vecchio come il cucù…

Video intervista a Gary Illyes

Al minuto 45:20 di questo video tratto dall’AMA session durante l’SMX Advanced 2015, Danny Sullivan pone una specifica domanda sul crawl budget al Google Webmaster Trends Analyst, Gary Illyes.

Articoli correlati

Autore

Commenti |6

Lascia un commentoCiao Giovanni, ho letto con molto piacere il tuo articolo su un aspetto che conoscevo. Però ho voluto comunque arrivare fino alla fine per la chiarezza espositiva. Un bell’articolo veramente. Non eccessivamente tecnico ma approfondito.

Grazie Francesco, spero di ritrovarti nei commenti di altri post :D

Eccellente articolo Giovanni, fa piacere leggere questa qualità di contenuti. Una domanda, pensi che usare ping services (e.g. Pingomatic) & social shares (G+, Twitter, etc.) possano essere d’aiuto?

Ciao Marco grazie per il commento.

I servizi di ping possono aiutare a velocizzare l’indicizzazione dei singolo contenuto. Secondo me non hanno un effetto degno di nota sul crawl budget.

Una condivisione su G+ invita googlebot a visitare la pagina, ma 1 visita è una goccia in mezzo al mare se confrontato col traffico di googlebot ricevuto in una giornata quindi, anche in questo caso, non ha secondo me impatto sul crawl budget.

A presto e buono studio ;)

Articolo interessante, come al solito.

Dovreste farne uno sul “render budget”

Grazie mille Andrea per il suggerimento! Ne terrò sicuramente conto per i prossimi articoli.