Hai già sentito parlare del Robots meta tag noindex? Riguardo questo importante aspetto precedentemente avevo spiegato:

- la differenza tra rel nofollow, ugc e sponsored

- avevo parlato anche dei meta robots

- e dell’intestazione HTTP X-Robots-tag.

In questa guida invece trovi un approfondimento dedicato all’attributo NOINDEX: come e quando usarlo per gestire l’indicizzazione delle tue pagine e gli errori da evitare.

Il tag meta robots noindex

La direttiva noindex è un meta tag che può essere aggiunto al codice sorgente HTML di una pagina web per suggerire ai motori di ricerca di non includere quella particolare pagina nel suo elenco di risultati di ricerca.

Per impostazione predefinita, una pagina web è impostata su “index”, ovvero quando trovata da un motore di ricerca è sottinteso che la pagina possa essere indicizzata. È necessario aggiungere una direttiva a una pagina web nella sezione <head> dell’HTML se non desideri che i motori di ricerca la indicizzino e la includano nelle SERP (la SERP è la pagina dei risultati dei motori di ricerca).

Quali sono esempi di pagine che dovrebbero essere “noindex”?

La scelta di applicare il tag noindex ad una pagina è personale e dettata da svariate ragioni, le più comuni tipologie di pagine tipicamente NOINDEX sono:

- Pagine di ringraziamento: se includi moduli di acquisizione di lead sul tuo sito web, come “Contattaci” o “Pianifica un appuntamento”, probabilmente indirizzi gli utenti dai tuoi form a pagine di ringraziamento univoche una volta che un utente invia un modulo. Avere pagine di ringraziamento uniche per ogni form è la migliore pratica per monitorare gli obiettivi. Tuttavia, se queste pagine vengono indicizzate dai MdR c’è il rischio che qualcuno possa arrivarci senza aver compilato il form di contatto, e questo rovinerebbe le tue statistiche di conversione. Un visitatore dovrebbe arrivare sulle tue pagine di ringraziamento solo dopo aver completato il tuo form di contatto. L’impostazione delle pagine di ringraziamento su “noindex” contribuirà a impedire che tali pagine vengano incluse nelle SERP.

- Pagine private riservate ai membri: se hai una sezione del tuo sito web dedicata ai tuoi dipendenti o membri dell’organizzazione, ma non desideri che tali pagine siano accessibili al pubblico o ai motori di ricerca, la direttiva “noindex” contribuirà a impedire che tali pagine vengano trovato in SERP.

Oltre a queste tipologie di pagine ci possono essere motivazioni più sottili e complesse che richiedono l’uso del tag NOINDEX, vediamone alcune.

- Pagine di bassa qualità che vuoi mantenere disponibili sul sito web e non desideri eliminare. È buona norma de-indicizzare pagine che non ricevono più traffico perché trattano argomenti “scaduti” oppure pagine di bassa qualità che non intendi aggiornare. Se il contenuto è utile per un lettore, lascialo indicizzato. Generalmente, dovresti taggare Noindex pagine con un valore SEO molto basso o dove non vuoi che la pagina sia accessibile tramite i risultati di ricerca.

- Pagine create per altri scopi di marketing, come ad esempio versioni online dell’email marketing, landing page per i social media, su cui non desideri che gli utenti della ricerca arrivino.

- Qualsiasi pagina che desideri nascondere al pubblico: ad esempio, una pagina privata raggiungibile solo da persone in possesso di un link specifico.

- Contenuti generati dagli utenti come le pagine poco attendibili di un forum. Ciò potrebbe includere post di utenti che non sono mai stati nel forum prima, thread che non hanno risposte e thread che non hanno risposte autorevoli.

- Contenuti duplicati. Nella maggior parte dei casi, è necessario utilizzare un tag canonical anziché un noindex per gestire contenuti duplicati. La canonizzazione dei contenuti consoliderà il posizionamento e i segnali sociali sulla pagina canonica, oltre a favorire la pagina canonica nei risultati di ricerca, rendendola l’opzione migliore per la gestione di pagine duplicate. Non indicizzare le pagine canonicalizzate le rimuove dall’indice, senza consolidare tutti i segnali che renderanno più forte la pagina principale. L’unica situazione in cui noindex sarebbe un’opzione utile per i contenuti duplicati sarebbe se non puoi utilizzare tag canonici: ad esempio, se il contenuto della pagina canonica è diverso da quello delle pagine canonizzate.

- Una norma abbastanza diffusa è usare il tag noindex sulla pagine di tag di WordPress dato che, nella maggior parte dei casi, sono pagine con contenuti di bassa qualità e duplicato.

Bloccare l’indicizzazione con “noindex”

Puoi impedire che una pagina appaia nella ricerca di Google includendo un meta tag noindex nel codice HTML della pagina, oppure restituendo un’intestazione “noindex” nella richiesta HTTP.

Quando successivamente Googlebot esegue la scansione di quella pagina e vede il tag o l’intestazione, Googlebot eliminerà completamente quella pagina dai risultati della ricerca, indipendentemente dal fatto che altri siti web possano aver linkato quella pagina.

Importante! Perché la direttiva noindex sia efficace, la pagina non deve essere bloccata da un Disallow nel file robots.txt. Se la pagina è bloccata da un file robots.txt il crawler non vedrà mai la direttiva noindex e la pagina potrà ancora apparire nei risultati di ricerca, ad esempio se altre pagine vi si collegano.

Come implementare il meta tag robots noindex

Il meta tag robots ti consente di utilizzare un approccio granulare e specifico per controllare come una singola pagina deve essere indicizzata e offerta agli utenti nei risultati di ricerca di Google. Esistono due modi per implementare noindex: come meta tag e come intestazione di risposta HTTP. Dal punto di vista SEO i due metodi hanno lo stesso effetto, scegli quello più conveniente per il tuo sito.

Meta tag robots NOINDEX

Per impedire alla maggior parte dei crawler web dei motori di ricerca di indicizzare una pagina sul tuo sito, inserisci il seguente meta tag nella sezione <head> della tua pagina:

<meta name="robots" content="noindex">Il valore dell’attributo name (robot) specifica che la direttiva si applica a tutti i crawler. Per definire un crawler specifico, sostituisci il valore robot dell’attributo name con il nome del crawler a cui vuoi fare riferimento. I crawler specifici sono anche noti come user-agent (un crawler utilizza il proprio user-agent per richiedere una pagina). Il crawler web standard di Google ha il nome di user-agent Googlebot. Per impedire a Googlebot di eseguire la scansione della tua pagina, aggiorna il tag come segue:

<meta name="googlebot" content="noindex">Questo tag ora indica a Google specificamente di non mostrare questa pagina nei suoi risultati di ricerca. Ricordati che sia il nome che gli attributi del contenuto fanno distinzione tra maiuscole e minuscole.

I motori di ricerca possono avere crawler diversi per proprietà o scopi diversi. Vedi l’elenco completo dei crawler di Google per maggiori dettagli. Ad esempio, per mostrare una pagina nei risultati di ricerca web di Google, ma non in Google News puoi utilizzare il seguente metatag:

<meta name="googlebot-news" content="noindex" />Per specificare più crawler singolarmente, utilizza più tag meta robot:

<meta name="googlebot" content="noindex">

<meta name="googlebot-news" content="nosnippet">Dovresti essere consapevole che alcuni crawler web dei motori di ricerca potrebbero interpretare la direttiva noindex in modo diverso. Di conseguenza, è possibile che la tua pagina venga comunque visualizzata nei risultati di altri motori di ricerca.

Un MdR deve scansionare la tua pagina per vedere i tuoi meta tag. Se la tua pagina taggata Noindex appare ancora nei risultati, probabilmente è perché lo spider non ha eseguito la scansione del tuo sito da quando hai aggiunto il tag. Puoi richiedere a Google di ripetere la scansione della tua pagina utilizzando Google Search Console. Un altro motivo potrebbe anche essere che il tuo file robots.txt sta bloccando questo URL dai crawler web di Google, quindi il bot non può vedere il tag. Per sbloccare la tua pagina da Google, devi modificare il file robots.txt e rimuovere la direttiva Disallow.

Utilizzare l’intestazione HTTP X-Robots-Tag

Il tag X-Robots può essere utilizzato come elemento della risposta dell’intestazione HTTP per un determinato URL. Qualsiasi direttiva che può essere utilizzata in un meta tag robot può anche essere specificata come tag X-robot. Ecco un esempio di una risposta HTTP con un tag X-Robots che indica ai crawler di non indicizzare una pagina:

HTTP/1.1 200 OK

Date: Tue, 25 May 2010 21:42:43 GMT

(…)

X-Robots-Tag: noindex

(…)Non approfondisco l’argomento dato che, come indicato ad inizio articolo, trovi una guida dedicata all’intestazione HTTP X-Robots-tag.

Ripristino di una pagina de-indicizzata per errore

Poiché un tag noindex è facile da aggiungere e rimuovere, è del tutto possibile che venga aggiunto alle pagine sbagliate o che altri membri del team possano fraintenderne l’effetto o lo scopo.

Ovviamente il primo e più importante passo nel recupero da un errore noindex è rimuovere il noindex. Dopo questo, dovresti:

- Inviare nuovamente la tua Sitemap a Google tramite Search Console.

- Inviare manualmente le pagine selezionate utilizzando la funzione “Invia all’indice”.

- Aggiungere gli URL non indicizzati al feed RSS e inviarlo in Google Search Console come Sitemap. Ciò dovrebbe contribuire ad accelerare la re indicizzazione del contenuto.

- Prendi in considerazione la possibilità di eseguire attività di inbound e marketing aggiuntivo tramite e-mail, canali social, guest post per cercare di integrare l’impatto del traffico mentre la pagina è fuori dall’indice.

Individuare errori noindex

Anche se questo errore non ti è ancora successo, è una buona idea usare gli strumenti che hai a disposizione per controllare regolarmente i problemi di noindex, specialmente nelle pagine ad alto traffico. Ricorda che un errore noindex può richiedere fino a un mese o più per avere effetto nei risultati di ricerca, a seconda della frequenza con cui Google esegue la scansione del tuo sito.

Fai attenzione ai forti cali del traffico organico in Google Analytics e alle pagine indicizzate in Search Console.

Per gli utenti avanzati la cosa migliore da fare è una scansione con Screaming Frog.

Un grave errore: Noindex e Disallow assieme

Noindex e Disallow non vanno mai usati assieme. La direttiva disallow nel robots.txt impedisce la scansione della pagina, pertanto i motori di ricerca non possono vedere la direttiva noindex.

Le pagine non indicizzate accumulano PageRank?

Nel 2012 Google ha dichiarato di eseguire la scansione di pagine non indicizzate, elaborare il contenuto e seguire i collegamenti, ma non mostra la pagina nell’indice. Nel 2007 Matt Cutts ha confermato che le pagine non indicizzate possono passare PageRank. Per essere sicuro che una pagina noindex possa trasmettere PageRank ti consiglio di usare la direttiva, Noindex, Follow:

<meta name="robots" content="noindex, follow">Posso includere pagine Noindex in sitemap.xml?

Le Sitemap.xml devono includere solo gli URL che desideri vengano visualizzati da Google e inclusi nei risultati di ricerca, quindi non includere pagine con un tag noindex in una Sitemap.

Differenze tra Disallow del Robots.txt e meta tag Noindex

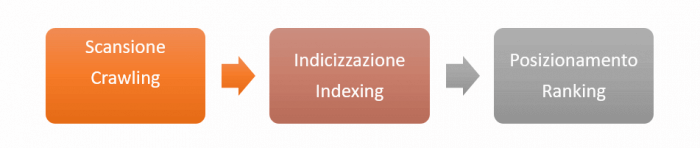

In passato avevo spiegato diverse volte cosa cambia tra scansione e indicizzazione. Nel caso ti fossi perso i riferimenti puoi ripartire leggendo Come indicizzare un sito web su Google e Come funziona Google (Easy Mode).

Ricapitolando in estrema sintesi: la scansione è la prima attività che Googlebot esegue quando trova una nuova pagina, se il contenuto è unico lo indicizza e se il contenuto è ricco di informazioni di qualità lo posiziona meglio degli altri.

Perché ripeto tutto ciò? Semplice, perché Disallow e Noindex agiscono su due momenti diversi del processo che porta una pagina dall’essere trovata dagli spider all’essere posizionata nei risultati di ricerca.

La direttiva Disallow agisce sulla scansione

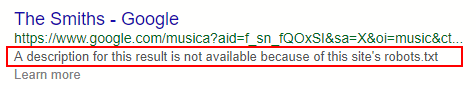

La direttiva Disallow è da inserire nel Robots.txt e richiede agli spider di non scansionare quella pagina. Una pagina non scansionata può comunque essere indicizzata, ad esempio se questa viene linkata da altri siti web o condivisa sui social network (in pratica se appare nel link graph).

Disallow: /pagina-da-non-scansionareCon la direttiva Disallow la pagina potrà quindi apparire nei risultati di Google come puoi vedere nella seguente immagine.

Il meta tag Noindex agisce sull’indicizzazione

Il meta tag Noindex agisce a livello di indicizzazione. Quando Googlebot scansiona la pagina e trova il tag meta Noindex la rimuove dal suo indice.

La pagina con meta tag Noindex non potrà quindi apparire nei risultati di Google.

<!-- Per impedire alla maggior parte dei motori di ricerca di indicizzare la pagina -->

<meta name="robots" content="noindex">

<!-- Per impedire solo a Google di indicizzare la pagina -->

<meta name="googlebot" content="noindex">

<!-- Se devi specificare più crawler singolarmente -->

<meta name="googlebot" content="noindex">

<meta name="googlebot-news" content="nosnippet">Articoli correlati

Autore

Commenti |21

Lascia un commentoCiao Giovanni, grazie per questa guida illuminante. Avrei una domanda su un concetto che non mi è chiaro… Riguardo questo paragrafo: Disallow e noindex insieme? Un grave errore.

Ma se un webmaster non vuole che una pagina venga indicizzata, a cosa serve che google la scansioni?

Ciao Elio,

con il disallow nel robots.txt Googlebot non potrebbe scansionare la pagina, quindi non leggerebbe il tag noindex.

Complimento per l’articolo.

Ho una serie di dubbi sule questioni no index e robot txt.

Spiego il mio caso:

-un sito, per cui sto gestendo un certo numero di campagne adwords, ha, per ogni campagna, una landing specifica (landing chiusa, senza link e solo info e form contatto).

-Non voglio che queste landing vengano fuori tra i risultati organici, ma usate unicamente per attività ads.

-che fare? usare robot txt per tutte quante?

-Visto che si tratta di un sito wp ed è installato yoast, ha senso impostare, per ogni singola landing “non consentire ai motori di mostrare la pag nei risultati “, insieme a “i motori di ricerca NON dovrebbero seguire questo link” ?

-In ogni caso dando queste direttive rischio di bloccare anche l’adsbot google (che invece vorrei attivo su queste pagine)?

-altre soluzioni possibili?

Spero di essere stato chiaro

Buonasera Bernardo, grazie per il commento.

Come avrà capito leggendo questa guida, il metodo corretto per non far apparire una pagina nei risultati dei motori di ricerca è usare il tag NOINDEX. La direttiva Disallow impedisce la scansione dei bot, ma non influisce direttamente sull’indicizzazione.

Con il tag NOINDEX non blocca alcun bot, quantomeno adsbot.

Non usi in alcun caso Disallow + NOINDEX perché gli spider, bloccati dal robots.txt, non potrebbero leggere il tag NOINDEX nell’HTML.

A presto!

Ricevuto, grazie della risposta.

Articolo molto interessante.

Se invece noto del traffico al mio sito su una pagina che non esiste più (da poco tempo ma alcune anche da molto tempo, o addirittura a file .pdf che erano contenuti in essa o in una directory) come faccio a dire a google di smetterla di mostrarla nei risultati? se esistesse dovrei usare il noindex, ma dato che la pagina non esiste più e restituisce una custom 404 (con anche codice 404) perchè google si ostina a mostrarla nei risultati?

Nel robots ho specificato di non scansionare le directory contenenti files .pdf etc. ma spesso mi trovo comunque traffico da google diretto verso i file, mentre io vorrei indicizzare solo le pagine che contengono tali file e non i pdf singoli.

anche in questo caso, una volta che io uso il robots per impedire di scansionare la directory con i pdf, come “cancello” dai risultati di google un’indicizzazione precedente?

Google dice che se un loro risultato porta a una pagina 404 automaticamente viene rimosso…come ragionamento funziona ma spesso noto che non è così.

Pareri?

Ciao Marco, grazie per la domanda.

Peri PDF puoi impostare il web server ad usare l’intestazione HTTP noindex.

Ad ogni modo, se metti il disallow su quegli URL google non potrà vedere lo status code 404, ti consiglio di lasciare il robots aperto in modo che Googlebot possa entrare e vedere che i file non ci sono più.

Con i 404 devi avere pazienza. Lasciali attivi, con il tempo Google toglierà quelle pagine dall’indice. Se vuoi provare a velocizzare usa lo status code 410.

Buongiorno Giovanni, complimenti per l’articolo.

La mia domanda riguarda le anomalie di scansione che vengono segnalate in Search Console.

La maggior parte delle anomalie mi vengono proposte ancora come dei URL con HTTP mentre altre sono in HTTPS nonostante da diverso tempo abbia fatto la migrazione da HTTP a HTTPS. È normale?

Nel caso delle anomalie di scansione è quindi consigliato utilizzare il Disallaw per evitare di far scansionare la pagina e sprecare crawl budget?

Grazie

Ciao Diego grazie per le domande.

Le segnalazioni su GSC non sono per forza problemi di cui preoccuparsi, ma avvisi che potrebbero o meno essere criticità da risolvere. Fare diagnosi del report Coverage/Copertura senza avere accesso ai dati è difficile, ma ci provo :)

Potrebbe segnalarti URL in HTTP nonostante tu abbia migrato per diverse ragioni: la prima è il tempo, a Googlebot serve del tempo per scansionare e canonicalizzare al protocollo HTTPS tutti gli URL del sito web dopo la migrazione. Altra ragione potrebbe essere avere canonical tag che ancora indicano URL in HTTP. Ultima ragione che mi viene in mente è avere link interni che puntano alla versione HTTP e non HTTPS. cosa che potrebbe rallentare il processo di canonicalizzazione.

Hai fatto una bella scansione con Screaming Frog?

La seconda domanda onestamente non l’ho capita, le anomalie sono aspetti che Google ti segnala per un controllo, ma a cosa ti riferisci?

Il disallow non è quasi mai la soluzione ideale, noindex e canonical sono spesso la prima scelta, ma dipende da caso e caso. Mi servirebbe avere più dettagli sulla segnalazione per darti un consiglio valido, magari una immagine o screenshot.

A presto e buon lavoro.

Grazie per la pronta risposta Giovanni.

Ciao Giovanni grazie per l’articolo. Ho una domanda a cui non trovo risposta da nessuna parte. Nel mio sito ho dei pdf in regalo per chi si iscrive alla newsletter. La pagina dei ringraziamenti con i contenuti e già noindex però i pdf che sono all’interno sono indicizzati. Come posso mettere l’attributo noindex ai media del mio sito? È possibile farlo?

Ciao Alberto, puoi impostare il web server ad inserire il noindex nell’intestazione HTTP dei file pdf.

Grazie mille Giovanni sei gentilissimo. Posso chiederti se queste stringhe vanno bene perché i pdf sono ancora indicizzati.

User-agent: *

Disallow: /pdfs/

Disallow: *.pdf$

Ciao Alberto, quelle che hai scritto sono direttive del robots.txt, io parlavo di intestazioni HTTP.

Il robots.txt non gestisce l’indicizzazione.

Mi sa che dovrò studiare ancora di più perché avevo inteso questo. Quello che mi hai scritto per me è una cosa nuova. Sto facendo tutto da autodidatta e non si finisce mai di imparare. Grazie ancora Giovanni sei gentilissimo. Buona serata

Grazie a te :) dovessi avere altri dubbi scivi!

Ciao Giovanni, grazie per questo prezioso articolo! Stavo approfondendo questo tema e ho letto in un libro che esiste una eccezione per l’utilizzo in combinazione dell’istruzione noindex e disallow.

In particolare il libro fa riferimento al caso di un grande portale di ecommerce in cui più schede prodotto – e i relativi parametri – generano URL che è difficile gestire con il parametro rel canonical.

In questo caso l’autrice suggerisce di inserire l’istruzione noindex nelle pagine e, una volta che si è accertati che non compaiono più in serp – di inserire nel robot.txt il comando disallow per queste pagine.

Mi è sembrata una tecnica molto audace e vorrei chiedere il tuo parere, se possible :)

Grazie,

Silvia

Ciao Silvia, grazie per la domanda.

Quallo che hai letto sul libro a mio parere è fattibile come strategia, ma un URL in disallow può venire comunque indicizzato nel caso venisse linkato da altri siti.

Facciamo un esempio – oggi non hai pagina indicizzate con un dato parametro e metti il disallow. Se domani qualcuno linka quel genere di pagine ti ritrovi un URL in disallow ma indicizzato, senza title e descrizione in SERP – che non è ottimale.

In genere il disallow si usa su URL tecnici e si gestiscono i parametri di pagine HTML con rel canonical o alla peggio noindex.

Ciao. vorrei chiederti come ti comporteresti se ti trovassi davanti al mio caso. Sul server che ospita il mio sito c’è un firewall chiamato fireshield. Sulla Search Console, in indicizzate ma non inviate, ogni giorno compaiono 5-6 url si questo tipo root/fireshield.js?t=.

Ho tentato di bloccare l’indicizzazione di queste url attraverso il disallow sul parametro ?t= sul robots.txt ma il discorso non cambia.

Cos’altro posso tentare?

Ciao Paolo, grazie per la domanda. La direttiva Disallow non chiede a Google di non indicizzare, ma semplicemente di non scansionare. Se Google trova link verso quella risorsa potrebbe comunque decidere di indicizzare l’URL.

Domande:

1) Hai provato a spostare il disallow dal parametro al file js?

2) Che hosting hai? Hai accesso alla configurazione del web server oppure è un hosting condiviso?

Si potrebbe procedere in due modi, in ordine di preferenza:

1) cambiando firewall. Ci sono applicativi firewall nativi nel web server, come ad esempio UFW.

2) configurando il web server ad inserire l’attributo NOINDEX nell’intestazione HTTP di quel file js.

3) continuare con il disallow del robots.txt sul file js ed avere pazienza, prima o poi Google, forse, capirà che quegli URL non sono per lui.

Grazie Giovanni, sapevo che avresti avuto una risposta.

Non ho provato a spostare il disallow al file js per cui provo. L’hosting in questione è un condiviso ma sicuramente posso provare a chiedere se possono inserire l’attributo noindex nell’intestazione http di quei files.

Dopo averti letto ne ho fatto subito richiesta.

Purtroppo il firewall viene fornito dall’hosting di default per tutti i piani per cui non posso cambiarlo.

Ti tengo informato qui. Ti tingrazio di nuovo!