Cos’è il robots.txt

Un robot.txt indica ai crawler dei motori di ricerca quali pagine o file il crawler può o non può richiedere al tuo sito. Viene utilizzato principalmente per evitare di sovraccaricare il tuo sito di richieste; non è un meccanismo per tenere una pagina web fuori da Google.

I proprietari di siti web utilizzano il file /robots.txt per fornire istruzioni sul proprio sito agli spider, in particolare può indicare quali aree del sito, cartelle o tipologie di file non debbano venire scansionate. In pratica funziona così: un crawler vuole visitare l’URL di un sito Web, ad esempio https://www.evemilano.com. Prima di farlo, verifica la presenza del robots.txt all’indirizzo https://www.evemilano.com/robots.txt e trova:

User-agent: *

Disallow: /- “User-agent: *” significa che questa sezione si applica a tutti gli spider.

- “Disallow: /” dice al robot che non deve visitare nessuna pagina del sito.

Questo robots.txt dice che niente deve essere scansionato, tutto il sito è in disallow e gli spider (in teoria) non possono entrare.

Un robots.txt completamento aperto invece sarebbe così:

User-agent: *

Disallow: Ci sono due importanti considerazioni quando si usa il /robots.txt:

- Gli spider possono ignorare il tuo /robots.txt.

- il file /robots.txt è un file disponibile pubblicamente. Chiunque può vedere quali sezioni del tuo server non vuoi che i robot scansionino. Quindi non provare a usare /robots.txt per nascondere le informazioni “delicate”.

Il file Robots.txt è necessario?

La maggior parte dei siti web non ha bisogno di un robot.txt. Questo perché di solito Google può trovare e indicizzare in autonomia tutte le pagine importanti del tuo sito, e cercherà di non indicizzare le pagine che non sono importanti o le versioni duplicate di altre pagine.

Blocked by robots.txt?

Il messaggio di errore “Blocked by robots.txt” può apparire in diversi strumenti: da Google Search Console, Screaming Frog e altri tool di diagnosi SEO.

L’errore si presenta quando lo spider dello strumento in questione cerca di recuperare una risorsa, che può essere una pagina web o una sua dipendenza (immagini, CSS, Javascript, font, …) ma il percorso del file è bloccato da una direttiva nel robots.txt.

Googlebot rispetta le direttive espresse nel robots.txt quindi ti avvisa che non può recuperare la risorsa. Per risolvere il problema devi rimuovere o modificare la riga che blocca l’accesso di Googlebot a quella specifica risorsa.

Cos’è una direttiva del robots.txt?

Se vuoi occuparti della SEO del tuo sito per prima cosa dovresti sapere a cosa serve il robots.txt. Riassumendo il discorso.

Il robots.txt è un file txt che contiene direttive destinate a tutti o specifici user-agent che definiscono quali aree, cartelle o file del sito possono o non possono venire scansionati.

Lo user-agent è il “nome” con cui un software si presenta ad un server per richiedere una risorsa. Il software può essere, ad esempio, un browser, un lettore multimediale oppure un bot dei motori di ricerca.

Una direttiva è quindi una regola che definisce a chi si rivolge e l’accesso al sito.

Perché è un problema se una risorsa è bloccata

Quando Google indicizza una pagina è come se salvasse nei suoi server una copia tale e quale della pagina, come appare sul browser di un utente. Non salva solo il testo ma tutta la pagina con il suo layout, le sue immagini e colori e tutti gli elementi che l’utente finale vedrebbe.

Cosa succede se il robots.txt impedisce a Googlebot di scansionare il file CSS, ad esempio? È semplice, non potendo leggere il file CSS Googlebot non potrà disegnare la pagina secondo lo stile definito nel CSS. la pagina finirà quindi nell’indice di Google senza stile e senza formattazione e questo potrebbe pregiudicare il buon posizionamento della pagina nei risultati di ricerca. In certi casi la pagina senza CSS potrebbe risultare a Google come non idonea ai dispositivi mobile.

Il robots.txt potrebbe bloccare una cartella del sito web con all’interno dei file JavaScript necessari a generare il main content nella pagina. Googlebot quindi non potrebbe vedere il contenuto e la pagina avrebbe seri problemi di posizionamento.

Come verificare se una pagina o risorsa è bloccata dal robots.txt

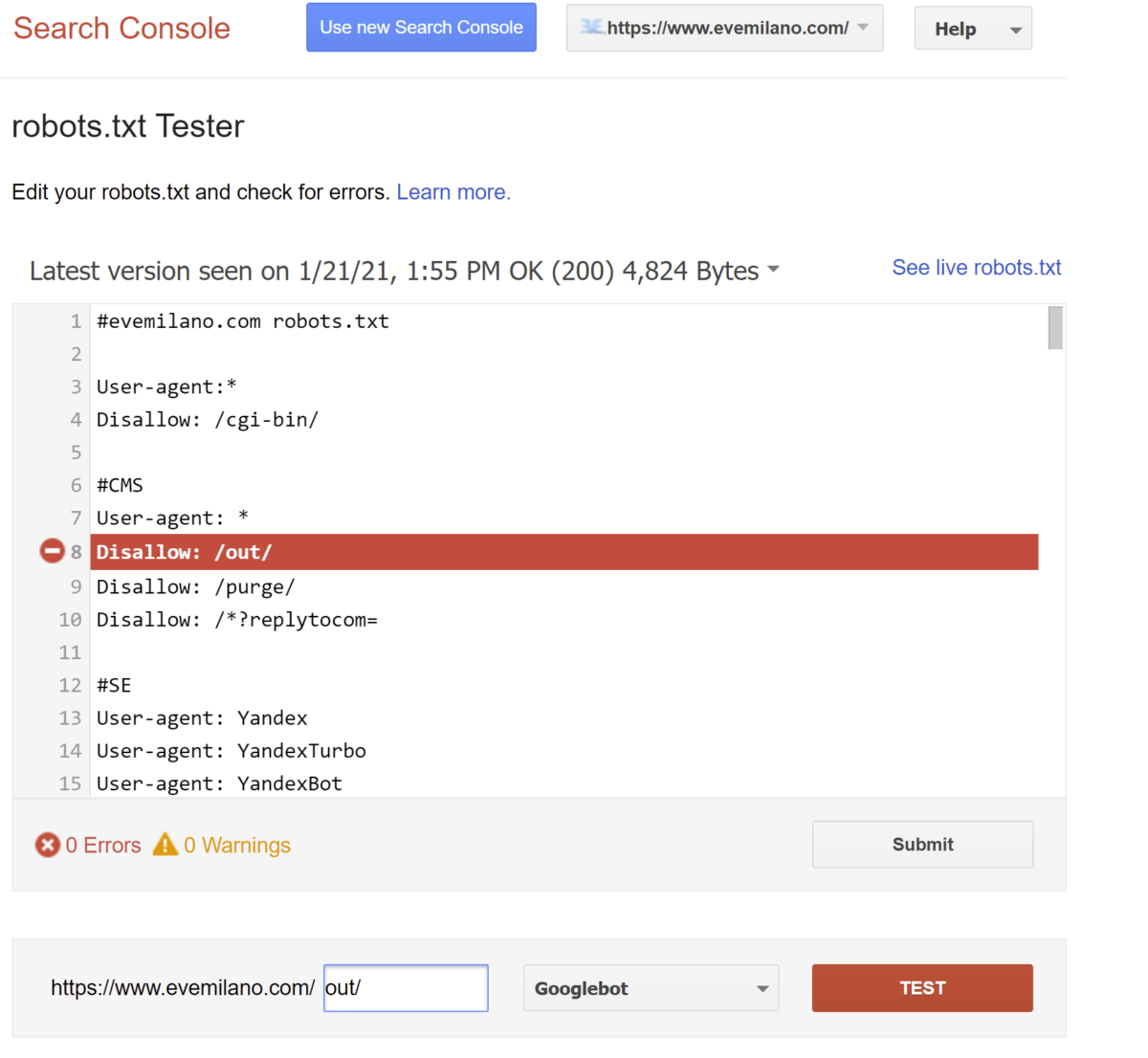

In Google Search Console è disponibile un tool per verificare se una risorsa è scansionabile da Googlebot. Lo strumento è raggiungibile a questo indirizzo.

Seleziona la tua proprietà (il sito web che vuoi verificare) e vedrai il robots.txt che Google ha salvato.

Sotto trovi un campo di input per inserire un URL di una pagina web o di una risorsa. Inserisci l’URL che vuoi testare, seleziona l’User-Agent di Google e premi TEST.

- Se l’URL è scansionabile vedrai il bottone ALLOWED (permesso).

- Se l’URL non è scansionabile vedrai il bottone BLOCKED. Inoltre, lo strumento evidenzia in rosso la riga nel file robots.txt che ha causato il blocco, così potrai rimuovere o correggere la direttiva.

Articoli correlati

Autore