Negative SEO: come i concorrenti possono rovinare il posizionamento del tuo sito web e come assicurarti che non ci riescano

La negative SEO è un argomento controverso. Ne abbiamo sentito parlare molto, ma accade davvero così di frequente? Quanto è facile rovinare il ranking di un concorrente? Dovresti essere preoccupato? Come fai a sapere se qualcuno sta cercando di buttarti fuori dalla SERP con tecniche di negative SEO? C’è qualcosa che puoi fare per stare al sicuro?

In questo articolo, farò del mio meglio per far luce sull’argomento e rispondere a queste domande. Ma prima di iniziare …

Cos’è la Negative SEO?

La negative SEO è un insieme di attività volte a ridurre il posizionamento di un sito web e la visibilità di un concorrente nei risultati dei motori di ricerca. Queste attività possono includere la creazione di spam, collegamenti non naturali al sito, scraping di contenuti e persino l’hacking del sito.

Personalmente non approvo la negative SEO, per forza di cose però ho a che fare con attacchi abbastanza di frequente, sia su questo blog sia su alcuni siti di clienti. Chi fa negative SEO non è capace di fare un buon lavoro SEO sul proprio sito e quindi cerca di rovinare la SEO degli altri, spesso perdendo tempo in attacchi che si annullano in 30 secondi.

Un po’ di storia

Fin dal primo giorno, Google ha fatto del suo meglio per identificare i backlink non naturali durante il processo di valutazione dell’autorità delle pagine web.

In origine, i link che Google riteneva essere spam venivano semplicemente ignorati: non passavano alcun PageRank alla pagina a cui si collegavano. In risposta, gli spammer iniziarono ad inserire migliaia (o talvolta milioni) di collegamenti; sui grandi numeri era più facile riuscire a creare qualche link in grado di passare equity (PR).

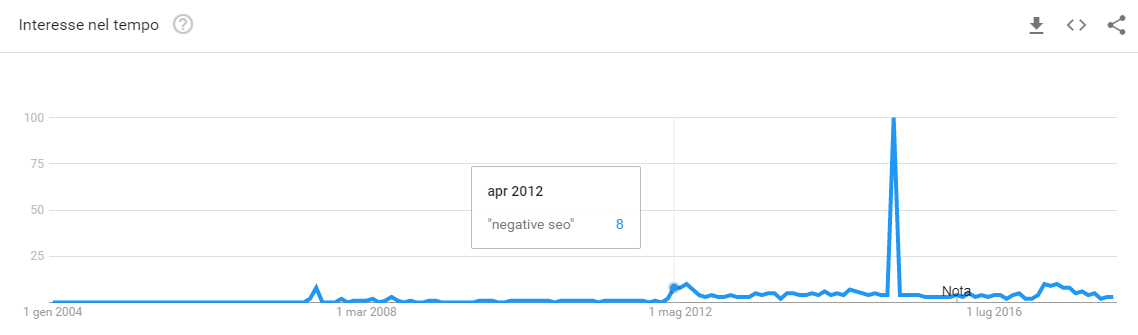

Nell’aprile 2012, Google ha lanciato l’aggiornamento Penguin con l’obiettivo di colpire i siti con link manipolativi riducendone la visibilità (in toto o in parte). Penguin ha aiutato Google a fornire risultati di ricerca migliori, più equi. Ma ha anche dato vita ad una serie di tecniche di negative SEO focalizzate sulla creazione di link di spam, come potete vedere da Google Trends di seguito.

Google ha qualcosa da dire in merito? Riconoscono che gli attacchi SEO negativi si verificano, anche se (dicono) non troppo spesso.

We work really hard to prevent these things from causing any problems. We work hard on our algorithms to try to recognize these kind of problems and catch them ahead of time. In practice I rarely see any issues around that and when I do see an issue where I think that maybe this is created by a competitor then usually the team is willing to look into the details and see what happened there and make sure that this isn’t an issue that is artificially causing problems for a website.

John Mueller – Webmaster Trends Analyst at Google

https://youtu.be/BAcEz_-ujCw?t=7m45s

Ora, diamo un’occhiata alle diverse forme di negative SEO ed esaminiamo i modi migliori di proteggersi da ciascuna di esse.

Come per la SEO, anche gli attacchi si suddividono in esterni al sito web (off-page) ed interni (on-page).

Negative Off-Page SEO

Come suggerisce il nome, la negative SEO off-page permette di attaccare un sito senza interferire internamente con esso. Più comunemente, questa tecnica implica la manipolazione di backlink di bassa qualità o la duplicazione esterna dei contenuti.

Link farm

Generalmente, un singolo link di spam (anche se presente in tutto il sito) non sarebbe in grado di rovinare la visibilità di un sito. Questo è il motivo per cui la negative SEO implica collegamenti da gruppi di siti di bassa qualità costruiti apposta, altrimenti chiamati “link farm”.

Una link farm è un hub di siti web interconnessi, spesso di infima qualità. Originariamente, questi siti utilizzavano collegamenti tra loro per aumentare la popolarità reciproca di ogni sito. In passato questi hub vendevano backlink finalizzati a manipolare il PageRank, ora questa tecnica è meno efficace ed i siti (inutili) vengono usati a danni di altri.

Un esempio di una link farm è un PBN – Private Blog Network (rete privata di blog): una rete di siti creati esclusivamente per la creazione di link e solitamente di proprietà di un singolo personaggio. Buona parte dei PBN sono costituiti da domini scaduti, il che significa che i siti hanno accumulato in passato alcuni backlink e autorevolezza.

Nel 2012, l’algoritmo di Google Penguin ha reso la vita molto più difficile per le link farm – se Google rileva collegamenti a ritroso che provengono da un link farm, giustamente conclude che il sito collegato è coinvolto in uno schema di link, il che porta naturalmente a una penalità. È così che le link farm sono passate dall’essere tecniche di black-hat efficaci a strumenti di negative SEO.

Per finire, colui che vuole attaccare può puntare molti link con ancora esatta verso un sito web, nel tentativo di rovinare il profilo di backlink. Le ancore a corrispondenza esatta potrebbero essere totalmente estranee al settore di appartenenza, ad esempio usando termini tipicamente spam legati al porno oppure relativi a medicinali di vario genere e natura. Una seconda possibilità è usare ancore molto specifiche del settore del cliente, ancore commerciali spinte, così da far apparire il profilo come manipolato.

Ovviamente per avere successo bisogna lavorare sui grandi numeri: generando migliaia di backlink malevoli, gli spammer hanno maggiore probabilità di infliggere un danno e, nello stesso tempo, il malcapitato avrà meno possibilità di identificare tutte le sorgenti maligne.

Questo attacco è efficace? Dipende. Se un SEO sta monitorando i backlink del sito si accorgerebbe subito dell’attacco ed in breve tempo lo annullerebbe con il disavow tool di Google. Tuttavia se il profilo di backlink non viene monitorato allora ci sono buone possibilità che un attacco ben assestato possa ridurre la visibilità del sito malcapitato.

Come proteggersi

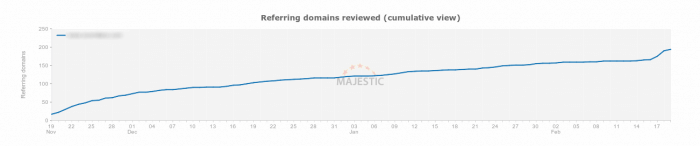

Prevenire un attacco di negative SEO non è qualcosa che è in nostro potere a meno che tu non possa prevedere il futuro. Individuare un tentativo abbastanza presto per annullarlo è invece totalmente fattibile. Per fare ciò, è necessario monitorare regolarmente la crescita del profilo di backlink. Majestic o Ahrefs, ad esempio, forniscono grafici di crescita sia per il numero di link del tuo profilo, sia per il numero di domini di riferimento. Un picco insolito in uno di questi grafici è una ragione sufficiente per esaminare i collegamenti che il tuo sito ha improvvisamente acquisito.

Monitora anche le ancore più usate e le pagine di destinazione, sono queste le aree dove è più facile individuare backlink strani. Ti consiglio di visitare personalmente ogni nuovo sito che ti linka, a volte ci sono sorprese inaspettate.

Salva in una lista tutti i domini che risultano essere spam ed usali nel disavow tool di Google.

Il disavow file deve essere inviato a Google in formato txt e deve essere compilato secondo una specifica sintassi. E’ possibile rimuovere singoli URL oppure interi domini.

Rifiuto di tutti i link dai domini elencati

domain:sito1.it

domain:sito2.com

…

Rifiuto dei link da una specifica pagina di provenienza

http://sito1.it/pagina.html

http://sito2.com/pagina.html

…

Ultima cosa ma non meno importante: verifica che il tuo web server risponda con status code 404 quando vengono richieste risorse inesistenti. Nel caso uno spammer linkasse verso www.tuosito.it/viagra-online, una risposta con status code 200 potrebbe far indicizzare la pagina, con ovvi risultati sulla qualità globale del sito web. Un web server ben configurato è un ottimo punto di partenza per difendersi da questo tipo di attacchi.

Scraper

Un’altra tecnica di negative SEO off-page si basa sulla generazione di contenuto duplicato. Questa tecnica comporta lo scraping del contenuto del tuo sito che viene poi copiato su altri siti web. Nei peggiori casi questi siti fanno parte di link farm sopra discusse. Il web scraping (detto anche web harvesting o web data extraction) è una tecnica informatica di estrazione di dati da un sito web per mezzo di software.

Probabilmente sai che l’aggiornamento di Panda di Google è stato progettato, in parte, per rilevare e combattere la duplicazione dei contenuti. Pertanto, quando Google trova contenuti duplicati su più siti, di solito assegna l’originalità ad un URL e tutti gli altri contenuti vengono considerati copie a cui non viene data visibilità in SERP. Tu speri che Google sia abbastanza intelligente da identificare la fonte originale del contenuto, e nella maggior parte dei casi lo è… A meno che la copia non venga indicizzata prima dell’originale.

Ti faccio un esempio classico. Ora tu pubblichi un contenuto e lo scraper lo copia subito sul proprio sito. Nel malaugurato caso in cui lo scraper abbia più crawl budget di te, oppure semplicemente Googlebot passa prima da lui, ci sono buone probabilità che la paternità del contenuto venga assegnata allo scraper. Il gioco è fatto.

Ecco perché gli scraper spesso copiano e pubblicano automaticamente i nuovi contenuti dai feed RSS. Se Google trova per prima la versione “rubata”, può declassare il sito originale e posizionare lo scraper.

Come proteggersi

Prima di tutto cerca di non fornire feed file (RSS) completi, inserisci solo l’estratto per ciascun articolo, magari il paragrafo iniziale. In questo modo gli scraper di RSS riceveranno solo una piccola parte del tuo contenuto. Se poi, nel primo paragrafo, riuscissi ad inserire un link verso il tuo sito, gli scraper distratti lo copieranno tale e quale e Google avrà più informazioni per capire la paternità del contenuto.

Se proprio non puoi ridurre il feed file devi monitorare le copie con costanza. Ci sono alcuni ottimi strumenti progettati per questo scopo, Copyscape è uno di questi. Tutto quello che devi fare è inserire l’URL dei tuoi contenuti per scoprire se ci sono duplicati online, totali o anche parziali.

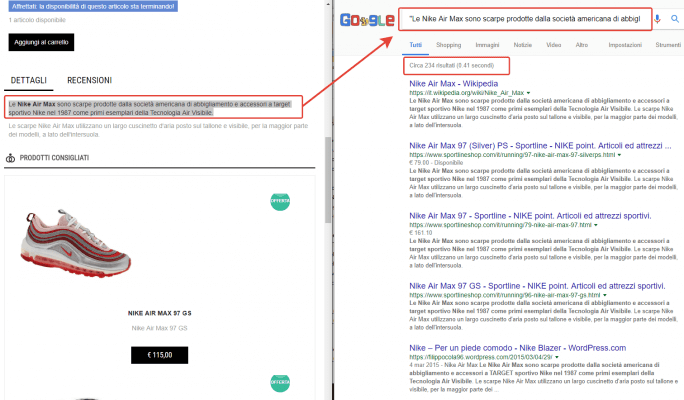

C’è un altro trucco che puoi usare direttamente su Google: cerca un breve estratto del tuo contenuto e mettilo tra virgolette “xxx yyy” per chiedere a Google l’esatta sequenza dei termini ricercati. Se trovi copie dei tuoi contenuti, è una buona idea contattare innanzitutto il webmaster chiedendo di rimuovere il pezzo (anche se potresti sospettare che non siano molto propensi a rispondere). Se questo non fosse efficace, potresti segnalare lo scraper utilizzando il rapporto di violazione del copyright di Google. Come ultima mossa potresti contattare un legale.

Recensioni false

Nella local SEO le recensioni significano molto. Un afflusso di recensioni negative non danneggia solo la visibilità locale, fa male agli affari in generale. Le recensioni sono relativamente facili da manipolare e potrebbero essere la prima cosa che un concorrente geloso proverà a fare. Probabilmente lo spammer ignora che, di fatto, sta rischiando una condanna.

Come proteggersi

Devi tenere sempre d’occhio la tua scheda di Google My Business e guardare le nuove recensioni della tua azienda. Le recensioni false possono violare le norme di Google, secondo le quali non si dovrebbe mai “pubblicare recensioni per conto di terzi o travisare la propria identità o connessione con il luogo che si sta esaminando”.

Quando hai individuato una recensione falsa, puoi segnalarla a Google e contrassegnarla per la rimozione seguendo questi passaggi:

- Accedi a Google Maps.

- Cerca la tua attività utilizzando il suo nome o indirizzo.

- Seleziona la tua attività dai risultati della ricerca.

- Nel pannello a sinistra, scorrere fino a Riepilogo di recensione.

- Sotto la valutazione media, fare clic su [numero di] recensioni.

- Scorrere fino alla revisione che si desidera contrassegnare e fare clic sull’icona della bandiera.

- Completa il modulo di segnalazione.

Inoltre nessuno ti vieta di richiedere assistenza ad un legale. Spesso basta una lettera ben scritta per far terminare queste attività illegali.

Scansioni invasive

Quando non sa fare di meglio, un concorrente disperato può provare a mandare in crash il tuo sito eseguendo una scansione forzata. Il carico eccessivo sul web server lo potrebbe far cadere, generando i fatidici errori 5xx. Se il tuo web server non regge molte richieste contemporanee, una semplice scansione multi-connessione con Screaming Frog potrebbe metterlo in ginocchio.

Una scansione invasiva potrebbe rallentare il sito o addirittura bloccarlo del tutto. Se i motori di ricerca non riescono ad accedere al tuo sito quando è inattivo, perderai sicuramente parte del crawl budget per indicizzazione; se questo accade per alcune volte di fila potresti perdere ranking o addirittura indicizzazione.

Come proteggersi

Se noti che il tuo sito sta diventando più lento o, peggio, si blocca del tutto, una cosa saggia da fare è analizzare il log del web server. In alternativa puoi contattare la società di hosting o il webmaster – dovrebbero essere in grado di dirti da dove viene il carico. Alla fine dovrai usare robots.txt e file.htacces per bloccare la porta agli spider/scraper più invasivi.

Ogni settimana controlla anche gli errori di scansione in Google Search Console: verifica in particolare la presenza di nuovi errori con status code 500.

Nel caso il tuo sito fosse solito subire attacchi, ti consiglio di usare il servizio Cloudflare. Questa CDN mette a disposizione anche un firewall per diversi tipi di attacchi, tra cui i famosi DDoS (Distributed Denial Of Service). Anche l’account gratuito usufruisce di questa protezione, valuta il suo utilizzo.

Click fraudolenti

I clic in SERP sono un segnale SEO controverso; non tutti credono che possano essere un fattore di ranking. Ci sono esperimenti che mostrano chiaramente che un tasso di clic (CTR) insolitamente elevato su un determinato risultato di ricerca possa migliorare il suo posizionamento; mentre un CTR basso otterrà un effetto opposto.

Esistono casi verificati di bot programmati per usare questa tecnica. In pratica si comportano così:

- I bot cercano su Google le parole chiavi rilevanti di un competitor.

- cliccano i risultati in SERP e si soffermano del tempo nelle pagine di destinazione, tranne che per i risultati del competitor.

- cliccano il risultato del competitor e appena atterrano nel suo sito tornano indietro in SERP.

- I bot devono eseguire elevati volumi di ricerche e successive azioni, in modo da rendere il comportamento statisticamente interessante agli occhi di Google.

Questo comportamento vuole comunicare a Google che la pagina visitata del competitor non è rilevante. In alcuni casi questa tecnica ha funzionato temporaneamente, Google ha declassato il risultato fino al termine delle ricerche artificiali.

Come proteggersi

C’è poco da fare per difendersi da questo attacco, se non altro per avere effetto l’attacco deve essere portato avanti per diverso tempo. Lo spammer dovrà investire giorni e risorse in questo attacco, infatti i risultati spariranno quando le query automatiche termineranno.

Quello che puoi fare è assicurati di monitorare attentamente il CTR delle parole chiave principali nella Search Console di Google. Qui troverai sia le statistiche sul CTR complessivo del tuo sito in tutte le parole chiave sia le percentuali di clic per le singole parole chiave.

Negative On-Page SEO

Gli attacchi SEO on-page sono molto più difficili da implementare da parte dello spammer. Questi attacchi infatti richiedono l’hacking del tuo sito.

Ecco le principali minacce SEO on-page che un hacker può portare ad un sito web.

Modifica del contenuto

Penseresti che sarebbe facile individuare contenuti modificati nel tuo sito, ma non è sempre così: in realtà questa tattica può essere molto sottile e difficile da individuare.

L’hacking del sito implica l’aggiunta di contenuto (e link) spam; il trucco è che questo contenuto è spesso ben nascosto (ad esempio, con “display: none”), quindi non lo vedrai a meno che non guardi attentamente nel codice HTML.

Come proteggersi

Prima di tutto assicurati di aver attivato le notifiche email di Google Search Console. Per verificare accedi allo strumento, clicca l’ingranaggio in alto a destra e seleziona Preferenze di Search Console.

Esegui audit regolari del sito con uno strumento come Screaming Frog, questo è il modo migliore per controllare il proprio sito contro tali minacce. Dovresti essere in grado di individuare modifiche che altrimenti potrebbero passare inosservate, come le ancore interne ed il numero di link in uscita dal sito.

Se non hai un crawler puoi provare a navigare il tuo sito disabilitando il CSS (prova questa estensione per Chrome): eventuali elementi nascosti diventeranno visibili.

Deindicizzare un sito

Una semplice modifica al file robots.txt potrebbe devastare l’intera strategia SEO. Una direttiva Disallow è sufficiente per dire a Google di ignorare completamente le tue pagine importanti o addirittura l’intero sito web.

Online ci sono molti esempi di questa cattiva tecnica. In questa vicenda un cliente, dopo aver licenziato l’agenzia SEO che lo seguiva, si è ritrovato un bel “Disallow: /” nel robots.txt. Come giocarsi la faccia e la reputazione agendo di stomaco…

Come proteggersi

Le verifiche periodiche ti aiuteranno a essere il primo a sapere se il tuo sito viene deindicizzato. Ogni settimana dai un occhio allo stato dell’indicizzazione su Google Search Console, e perché no, anche al file robots.txt. Inoltre ricordati di tenere al sicuro password FTP e SSH.

Modifica delle regole di redirect e URL Hijacking

Quando un hacker accede alla tua macchina può fare quello che vuole, anche modificare le regole di redirect. Se il tuo sito gode di grande autorità e link popularity, redirezionare il traffico è un modo subdolo di aumentare il PageRank del proprio sito o semplicemente di “rubare” i visitatori. Se Google rileva il reindirizzamento prima di te, può penalizzare il sito per “reindirizzamento a un sito web dannoso”.

Come proteggersi

Scansiona il sito regolarmente e dovrebbe essere abbastanza facile per te vedere se sono stati aggiunti nuovi reindirizzamenti. Monitora anche lo stato dell’indicizzazione e segnati il numero di pagine indicizzate mese dopo mese.

Nota: ci sono alcuni siti web che usano un sistema di redirect interno per linkare siti web esterni. Ad esempio, invece di linkare direttamente “sitoesterno.com” usano un sistema che genera link interni tipo: “https://miosito.com/redirect.php?url=https://sitoesterno.com/“. Questo sistema apre le porte ad un noto attacco di negative SEO detto URL hijacking. Infatti, nel momento in cui un hacker lo scopre, potrebbe creare link verso i suoi siti web, passando dal dominio in questione, rubandone l’autorevolezza. Inutile dire che sconsiglio questi sistemi di redirect interni a meno che non ci sia una verifica a monte sulla correttezza del link in uscita.

Hacking generico del sito web

Anche se l’hacker non ha in mente attività specifiche di negative SEO, un attacco di per sé può danneggiare la tua SEO. Google vuole proteggere i suoi utenti e non vedrà di buon occhio i siti che ospitano malware (o il collegamento a siti che lo fanno). Per questo motivo, se Google sospetta che un sito sia stato violato, potrebbe deindicizzarlo, o per lo meno aggiungere una riga “questo sito potrebbe essere compromesso” ai tuoi risultati in SERP.

Come proteggersi

Negative SEO a parte, non essere hackerato dovrebbe essere in cima alla lista delle priorità per ovvi motivi. Questo argomento meriterebbe un post tutto suo, ma posso riassumere le linee guida più importanti:

- Aggiorna il server se emergono criticità con le versioni software che hai installato.

- Aggiorna il CMS appena escono le versioni stabili.

- Restringi gli accessi utente al CMS, alla macchina e al server FTP.

- Se possibile non installare un server FTP ma usa SFTP – SSH File Transfer.

.

- Resta aggiornato, tu, non la macchina! Leggi quello che succede nel settore e conosci i possibili attacchi.

- Restringi le regole per password più sicure.

- Usa un firewall (WaF) sul tuo server.

- Installa applicazioni orientate alla sicurezza, come WordFence per WordPress.

- Nascondi le pagine di amministrazione.

- Limita il numero e la dimensione degli upload.

- Usa il protocollo SSL.

- Ultimo ma non meno importante – esegui backup costanti ed esterni alla macchina!

In questa guida ho trattato le tecniche di negative SEO più comuni e ti ho suggerito alcuni metodi per proteggerti. Questo elenco tuttavia non è esaustivo: nascono nuove tecniche ogni giorno che possono essere usate contro di te. Ricordati di monitorare il traffico organico, il ranking ed i backlink.

Se hai suggerimenti per favore lascia un commento qui sotto!

Articoli correlati

Autore

Commenti |2

Lascia un commentoSalve, vorrei informarvi che cliccando sulla tabella alla voce SCANSIONI INVASIVE l’ancoraggio è errato e porta alla voce “Click fraudolenti”.

Sperando di avere fatto cosa gradita, saluto e ringrazio per l’ottimo articolo informativo.

Ciao Gianmarco, grazie della segnalazione, problema corretto.